Warum wirkt künstliche Intelligenz für viele so unheimlich, und wie lässt sich dieses Gefühl überwinden? Dieser Beitrag geht diesen Fragen nach, zeigt psychologische Mechanismen, wirft einen Blick auf die Geschichte der KI und liefert Denkansätze, wie ein sachlicherer Umgang mit der Technologie möglich wird.

Künstliche Intelligenz, objektiv betrachtet

Zum Thema KI lässt sich eine emotionsgeladene öffentliche Debatte beobachten, in der Panikmache und Mythen oft mehr Aufmerksamkeit erhalten als technische Fakten [Anmerkung: ein ausführlicher Beitrag dazu ist bei Wissenschaftskommunikation.de verfügbar]. Doch wenn die Grenze zwischen Fantasie und Wirklichkeit verwischt wird – da hatte Freud (1919, S. 258) tatsächlich recht – dann wirkt das auf die Rezipient:innen unheimlich. Das belastet den Diskurs über KI, weil die notwendige Differenzierung zwischen realen Chancen/Risiken und spekulativen Szenarien erschwert wird.

Um das unheimliche Image der KI aufzubrechen und einen objektiven Blick auf das Thema zu ermöglichen, sind m.E. zwei Schritte nötig

- Ein Verständnis dafür aufzubauen, warum KI unheimlich wirkt und welche Bandbreite von menschlichen Reaktionen dadurch entsteht.

- Zu lernen, KI, wie wir sie heute kennen, als das Ergebnis jahrzehntelanger Entwicklung und Forschung zu verstehen, das sie ist.

Klingt interessant? Dann lesen Sie am besten weiter!

Warum uns Künstliche Intelligenz so unheimlich vorkommt

Es liegt in der menschlichen Natur, Unbekanntem mit einer gewissen Skepsis zu begegnen. In der Sozialpsychologie ist diese Reaktion gut belegt. Der sogenannte Mere-Exposure-Effekt, erforscht von Robert B. Zajonc, beschreibt, dass wir auf neue Dinge zunächst mit Ablehnung oder Spott reagieren, später mit Neugier, und schließlich mit Akzeptanz oder sogar Sympathie.

Genau diese Dynamik lässt sich auch in der öffentlichen Wahrnehmung von KI beobachten, besonders seit dem Durchbruch generativer Systeme in den letzten zwei Jahren. Da ist die Angst vor Jobverlust, die in Medienberichten immer wieder auftaucht. Zugleich kursieren spöttische Memes, die sich über KI-Fails lustig machen. Es häufen sich auch Anekdoten von „Wow“-Momenten von User:innen, die zum ersten Mal mit einem LLM oder Bildgenerator interagieren. Und schließlich hören wir vermehrt von Menschen, die sagen, ChatGPT sei aus ihrem Alltag nicht mehr wegzudenken – sei es beim Lernen, beim Programmieren oder für niederschwellige Beratung in Krisensituationen.

Darüber hinaus wird mit dem KI-Hype auch mediales Kleingeld verdient. Zum Beispiel wird in reichweitenstarken Podcasts wie All-In regelmäßig über KI spekuliert – oft in dramatischem Ton und mit wenig technischer Präzision. So sprach Co-Moderator und Investor David Sacks jüngst von einer „globalistischen Agenda“, warnte vor einem „AI Existential Risk Industrial Complex“ und einer „woken Regulierungsideologie“. Mal ist von einer drohenden „Versklavung durch Maschinen“ die Rede, mal von Regierungen, die mithilfe von KI ein „Orwell’sches Kontrollregime“ errichten könnten (Zvi Mowshowitz hat die Episode ausführlich dokumentiert und kommentiert). Solche Zuspitzungen erzeugen Aufmerksamkeit, verwischen jedoch die Grenze zwischen Science-Fiction, politischem Framing und wissenschaftlicher Forschung.

Um KI zu verstehen und über sie zu sprechen ohne in Angst, Hype oder Verschwörungstheorien abzudriften, hilft ein Blick in die Vergangenheit. Denn künstliche Intelligenz ist eigentlich nichts Neues.

Eine kurze Geschichte der KI

Schon in den 1950er-Jahren forschten Pioniere wie Alan Turing und John McCarthy an der Idee, Maschinen zu bauen, die „denken“ können. Auf der berühmten Dartmouth-Konferenz von 1956 wurde der Begriff Artificial Intelligence geprägt, begleitet von der kühnen Erwartung, dass menschliche Intelligenz innerhalb kurzer Zeit technisch nachgebildet werden könne. Dieser Optimismus zeigte sich in den folgenden Jahren auch in Äußerungen von Forschern wie Marvin Minsky, der 1967 erklärt, dass das Problem der künstlichen Intelligenz „innerhalb einer Generation“ im Wesentlichen gelöst sein werde. Diese Erwartungen erfüllten sich nicht: Viele Herausforderungen erwiesen sich als weitaus komplexer als zunächst angenommen. Statt selbstständig denkender Maschinen entstanden zunächst Schachprogramme und andere spezialisierte Systeme, die nur in sehr engen Bereichen überzeugen konnten.

In den folgenden Jahrzehnten wechselten sich Phasen der Euphorie und Ernüchterung ab. Nach den großen Ankündigungen der 1960er-Jahre folgte in den 1970er- und 80er-Jahren der sogenannte „KI-Winter“: die mageren Ergebnisse der KI-Forschung brachten die Finanzierung zum Versiegen. Maschinelles Lernen gab dem Feld in den 1990er- und 2000er-Jahren dann neuen Auftrieb. Spätestens als 1997 IBMs Deep Blue den amtierenden Schachweltmeister Garri Kasparow besiegte, wurde KI auch in der breiten Öffentlichkeit zum ersten Mal wahrgenommen.

Parallel dazu fand KI langsam und überwiegend unbemerkt ihren Weg in den Alltag. Spamfilter, Übersetzungsdienste, Navigationssysteme, Bilderkennung im Smartphone oder personalisierte Empfehlungen in Onlineshops – all das basiert seit Jahren auf maschinellem Lernen. Viele dieser Anwendungen wurden seit den 2000er-Jahren durch bessere Datenverfügbarkeit und schnellere Rechner deutlich leistungsfähiger und flächendeckend eingesetzt, lange bevor ChatGPT & Co. im Rampenlicht standen. Auch in anderen Bereichen ist KI längst etabliert: in der Medizin zur Unterstützung bei Diagnosen, im Finanzsektor zur Betrugserkennung oder in der Industrie zur Optimierung von Produktionsprozessen. Künstliche Intelligenz ist also nicht plötzlich über uns hereingebrochen, sondern schrittweise in unser Leben eingesickert.

Der sichtbare Sprung der letzten Jahre hängt mit neuen technischen Möglichkeiten zusammen: leistungsfähigere Prozessoren, riesige Datenmengen und vor allem neue Modellarchitekturen. Auf dieser Basis konnten generative Sprach- und Bildmodelle wie GPT oder Stable Diffusion entstehen, die uns heute beeindrucken. Sie wirken wie eine radikale Zäsur, sind aber in Wahrheit das Resultat eines jahrzehntelangen Forschungsprozesses, in dem Theorie, Hardware und Daten Schritt für Schritt zusammengewachsen sind.

Dass damit auch Verunsicherung einhergeht, ist nachvollziehbar. Für viele wirkt es so, als sei KI „plötzlich da“, obwohl die Entwicklung langsam und kontinuierlich verlief. Dieser Kontrast zwischen Wahrnehmung und Realität verstärkt das Gefühl des Unheimlichen, das es für objektiven Diskurs zu überwinden gilt.

Das Uncanny Valley überwinden

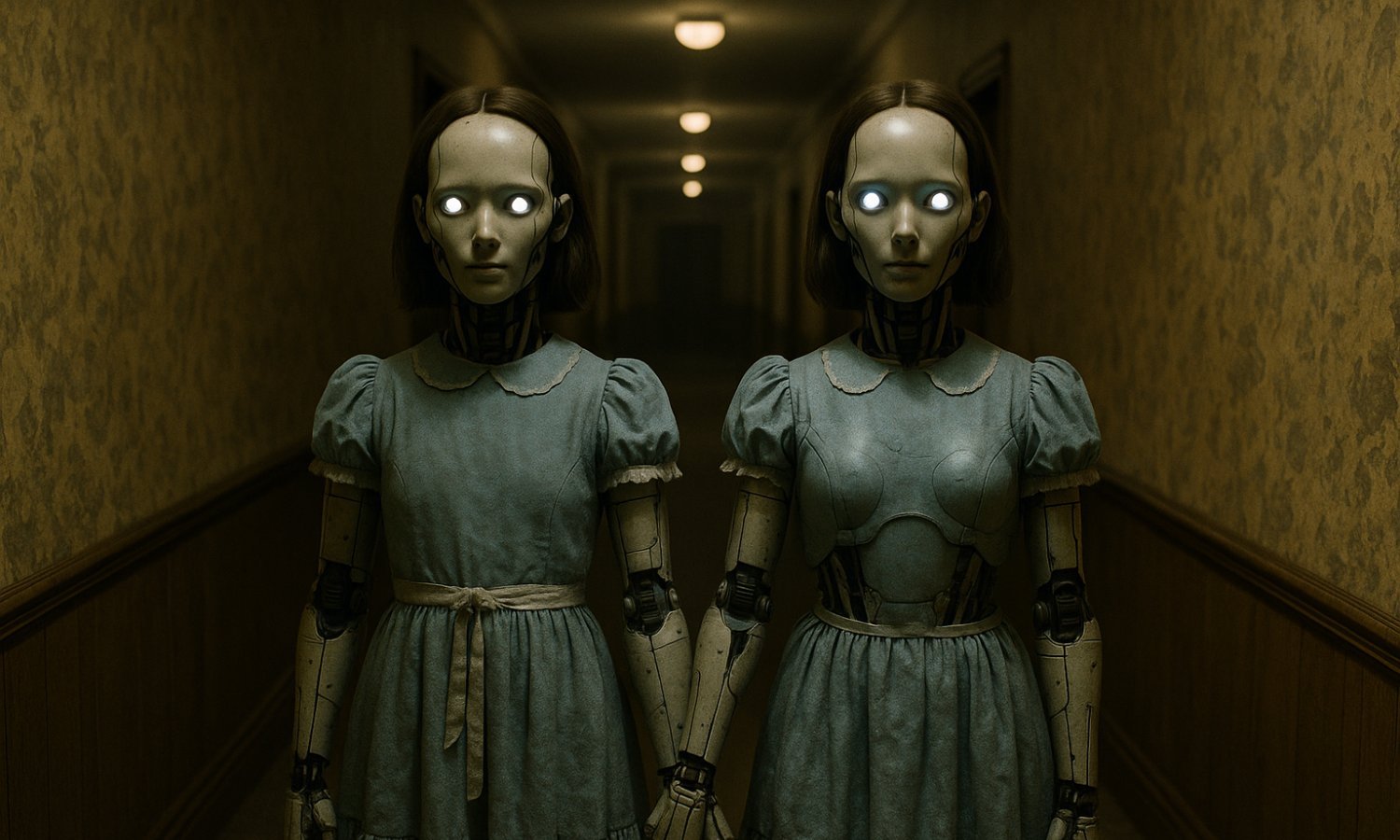

Das „Uncanny Valley“ beschreibt das Gefühl des Unheimlichen, wenn etwas fast, aber nicht ganz menschlich wirkt – etwa ein humanoider Roboter oder ein KI-Avatar. Ein ähnliches Unbehagen prägt die gesamte Debatte über KI: Sie erscheint oft mächtiger und fremder, als sie tatsächlich ist.

Überwinden lässt sich das nur durch objektive Einordnung. KI ist weder Magie noch unmittelbare Bedrohung, sondern das Ergebnis jahrzehntelanger Forschung mit klaren Stärken und ebenso klaren Grenzen. Wer Mythen von Fakten trennt und über Chancen wie Risiken gleichermaßen spricht, schafft die Grundlage für einen sachlichen Diskurs – und nimmt der KI das Unheimliche.

Bibliografie

Freud, S. (1919). Das Unheimliche . In: Jahrbuch für psychoanalytische und psychopathologische Forschung, Bd. 1.

Minsky, M. L. (1967). Computation: Finite and Infinite Machines. Englewood Cliffs (NJ): Prentice-Hall.

Zajonc, R. B. (1968). Attitudinal Effects of Mere Exposure. Journal of Personality and Social Psychology Monograph Supplement, 9 (2, Pt. 2), S. 1–27.

Pingback:„Zwischen apokalyptischen Warnungen und utopischen Visionen“ – Johannes Zeller mit Gastbeitrag auf Wissenschaftskommunikation.de über Künstliche Intelligenz | gwup | die skeptiker

Absolut richtig. Alles hat seine Grenzen. Wenn es um die feine Klinge geht, dann ist der Mensch klarer Sieger.